智东西尊龙凯时(中国)官方网站

智东西尊龙凯时(中国)官方网站

智东西11月5日音信,刚刚,华为精良开源了UCM(Unified Cache Manager)推理驰念数据处置,这是一项针对AI推理加快的要津技艺。

▲GitCode边幅页面

本年8月12日,华为精良发布了UCM技艺,发布会上华为公布,经无数测锻真金不怕火证,UCM可将首Token时延最高裁减90%,系统隐晦最大进步22倍,已毕10倍级高下文窗口延长,AI推感性能显贵进步。

▲8月12日UCM技艺发布,图源:智东西

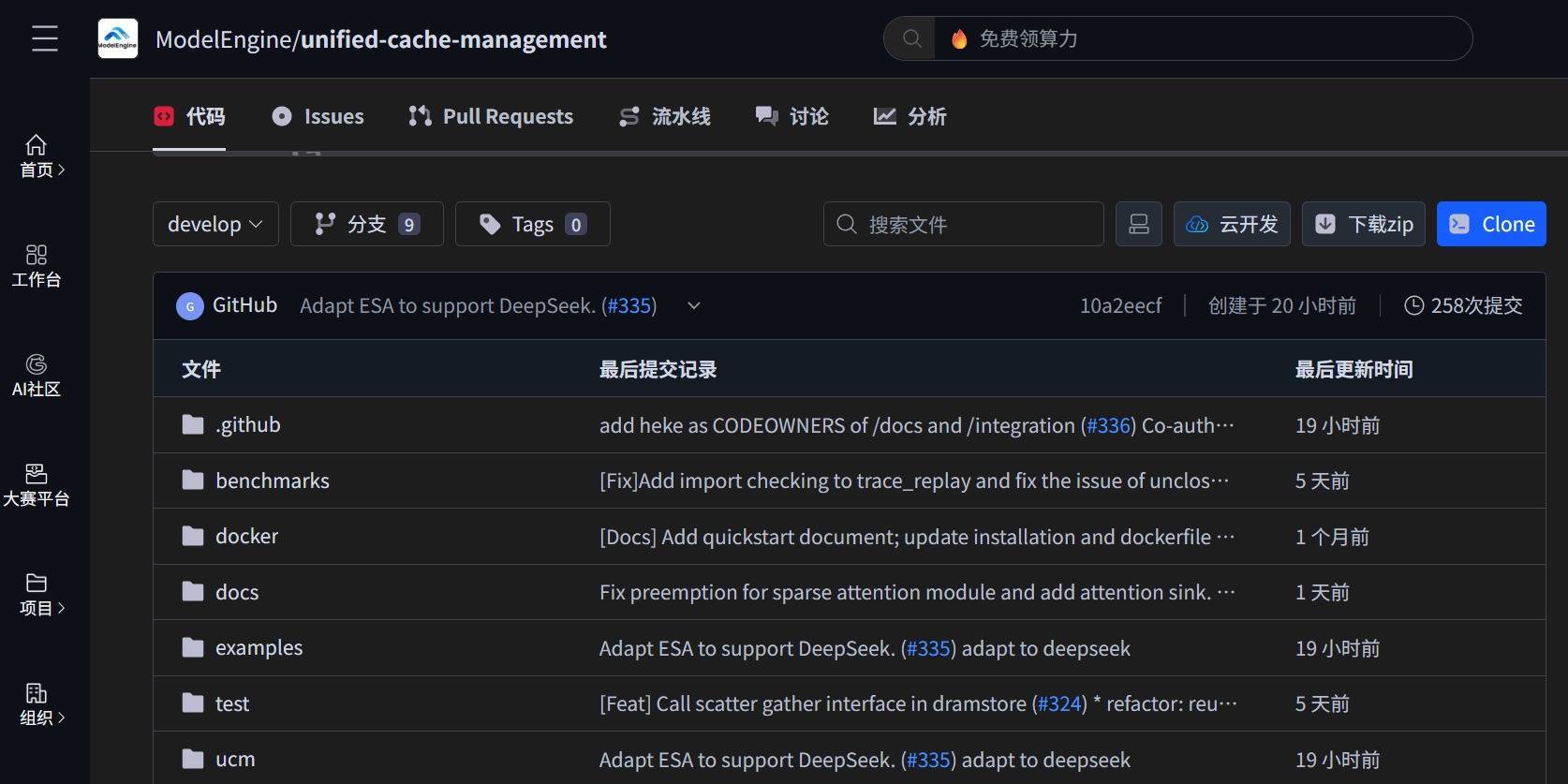

时隔近3个月,这一技艺精良开源,比发布会上瞻望的9月稍晚。现在UCM在ModelEngine社区通达了基础框架和器具链,建造者不错在社区得到UCM源代码和技艺文档。

▲Github边幅页面

GitCode开源地址:

https://gitcode.com/ModelEngine/unified-cache-managementGithub开源地址:

https://github.com/ModelEngine-Group/unified-cache-management总体来看,UCM所以KV Cache和驰念处置为中心的推理加快套件,不错提供全场景系列化推理加快决策,通过推理框架、算力、存储三层协同,优化Tokens在各业务模范中流转的效果,破解长序列推理效果低、本钱高的鬈曲,以已毕AI推理的更优体验、更低本钱。其主要工作对象是企业用户。

Agentic AI期间,AI推理的KV Cache容量增长已超出HBM的承载才气。通过一系列算法,UCM可凭证驰念热度在HBM、DRAM、SSD等存储介质中自动分级缓存,进步通盘系统的效果,一定进度上裁减对HBM的需求。

UCM会通了多类型缓存加快算法器具,可分级处置在推理过程中产生的KV Cache驰念数据。

UCM架构包含多个协同责任的要津功能模块,具体如下:

·UCM稀少化模块 (UcmSparseBase):兼容多种稀少算法的和谐基类,负责稀少KV Cache Block的卸载、加载与计较,已毕“零感知”插拔式稀少化。在不影响合座推理历程的前提下,大要机动适配不同稀少算法以进步推理效果。

·稀少化KV处置器 (SparseKVManager):面向算法级定制的KV Cache Block分派总控器,各稀少算法以多态子类样式将自要素配逻辑注入框架,已毕不同稀少算法计策与推理引擎解耦,清闲各别化推理场景需求。

·KV Cache存储组件 (UcmKVStoreBase):负责提供与外部存储通讯的通用接口。该组件提拔稀少算法与存储后端解耦,可无缝对接浪漫存储系统,同期提拔前缀缓存,为数据存储提供了机动千般的聘请。

·UCM相接器(UC Connector):桥接KV Cache存储组件与推理引擎,保险数据在不同组件之间的高效传输,已毕高可靠的前缀缓存才气。

▲UCM家具架构

图中统统灰色框代表vLLM 0.9.2版块中的现存类,绿色框则代表UCM新增组件。浅绿色框展示了基于此框架异日陆续延长的子类。

基于以上架构,UCM现在具备四个要津才气:稀少留意力、前缀缓存、预填充卸载、异构PD解耦。

作念UCM的动机是什么?

凭证GitCode官方信息,现时跟着模子尺寸的不休增长,KV缓存也变得越来越大,且越来越稀少,关于长序列苦求来说尤为显著。为了减小GPU显存的使用,主流的标的是将全量的KV数据卸载到外部存储中,而在GPU显存中只保留部分或者被压缩的KV数据。这同期不错减小GPU的运算量,在解码时加多最大生成序列长度和批大小。

有很多种不同的稀少KV缓存的已毕。最新的论文指出,大要最佳地适配统统场景和统统模子的措施是不存在的。因此,更好的作念法是搭建一套全球的框架,并在此之上接入不同的稀少化算法,就像KV相接器和PC相通。

凭证GitCode官方信息,UCM的中枢旨趣是合手久化LLM的KVCache,并通过多种检索机制替代冗余计较。UCM提拔前缀缓存(prefix cache,PC),同期提供了多种无需教练的稀少留意力检索措施,在处理极长序列推理任务时达到更高性能;此外,UCM基于存算永诀架构提供了PD永诀决策,使得异构计较资源的处置更肤浅机动。

结语:交接性能挑战,缓解资源瓶颈,UCM开源或加快AI推理落地跟着角落和端侧AI的快速发展,AI推理需求快速增长,在Agentic AI期间,AI推理任务愈发复杂,对算力、内存侦察效果等方面齐建议了更多挑战。

UCM的开源尊龙凯时(中国)官方网站,不错进一步缓解AI推理复杂任务产生的资源瓶颈和性能挑战,给行业提供新的技艺旅途,加快优秀商用AI推理决策的落地。