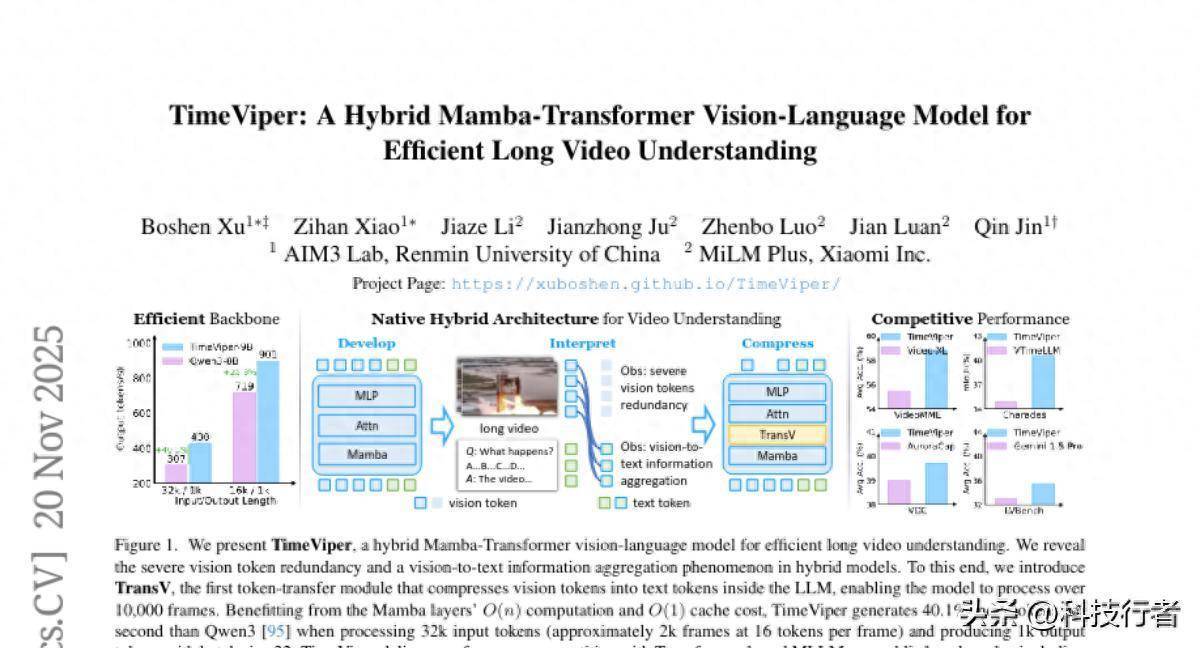

这项由清华大学东说念主民大学AIM3实验室的徐博申、肖子涵等研讨者与小米公司MiLM Plus团队协调完成的研讨,于2024年11月发表在arXiv预印本平台,论文编号为arXiv:2511.16595v1。该研讨初次建议了一种野蛮高效处理超长视频的羼杂架构视觉语言模子TimeViper,记号着AI视频领路能力的垂危碎裂。

设想一下,若是要让一个东说念主看完一部两小时的电影然后回应问题,这对东说念主类来说并不艰辛。但对于现存的AI系统,这却是一个远大的挑战。大多数AI模子在处理视频时就像是一个回顾力有限的学生,看了几分钟就出手健忘前边的内容,更别说领路长达数小时的视频内容了。清华大学和小米的研讨团队刚毅到了这个问题的关节性,因为在践诺应用中,不管是安防监控、教训培训,如故文娱内容分析,咱们持续需要处理的都是万古间的视频素材。

传统的AI视频领路模子濒临两个主要窘境。第一个窘境可以比作一个计划能力有限的大脑,当视频变万古,处理所需的计划资源会急剧加多,就像试图同期记着成千上万个细节一样让东说念主不胜重担。第二个窘境则是信息冗余问题,视频中存在大批访佛或不垂危的画面,就像一册书里有许多访佛的段落,占用了贵重的"平安力"资源。

研讨团队的措置决策TimeViper给与了一种精巧的羼杂架构运筹帷幄。这种运筹帷幄就像是组建了一个专科的视频分析团队,其中Mamba层雅致快速浏览和回顾万古间序列信息,就像一个善于速读的助手,野蛮快速扫描大批内容并记着关节信息。而Transformer层则像是一个雅致的分析师,专注于深入领路和分析垂危细节。这两种不同特长的"职工"协同劳动,既保证了处理效劳,又保管了领路质地。

更令东说念主印象深切的是,研讨团队在分析这种羼杂架构时发现了一个道理的满足,他们称之为"视觉到文本信息团员满足"。这就好比在看电影的过程中,不雅众来源会被各式视觉细节劝诱,但跟着剧情深入,这些视觉信息会渐渐会通成对故事情节和东说念主物的领路,最终酿成可以用语言抒发的领略。在AI模子中,也发生着类似的过程:在处理的早期阶段,模子专注于视觉token的细节,但在后期阶段,这些视觉信息会渐渐积累到文本token中,酿成可以用天然语言抒发的领路。

基于这个发现,研讨团队运筹帷幄了TransV模块,这个模块的劳动道理就像是一个智能的信息整理助手。当发现某些视觉信息一经被充分领路并转变为语言意见后,TransV会将这些冗余的视觉token压缩调动,开释出更多的计划资源用于处理新的内容。这种机制使得TimeViper野蛮处理进步10000帧的视频内容,极度于可以分析数小时的高清视频素材。

一、羼杂架构的运筹帷幄灵巧

TimeViper的中枢更始在于其羼杂架构运筹帷幄,这种运筹帷幄精巧地衔尾了两种不同AI技艺的上风。可以把这个运筹帷幄设想成一个高效的藏书楼系统:Mamba层就像是藏书楼的快速检索系统,野蛮飞速定位和纪录大批竹素的位置信息,处理速率极快且占用的存储空间很小。而Transformer层则像是专科的研讨助理,天然劳动较慢,但野蛮深入分析每本书的详备内容,领路复杂的意见相干。

在具体竣事中,TimeViper给与了27个Mamba-2层、4个自平安力层和25个MLP层的成立。这种成立比例经过全心运筹帷幄,确保了效劳和性能的最好平衡。Mamba-2层通过情景空间模子来爱戴一个紧凑的阴私情景,这个情景就像是一个不休更新的"回顾摘抄",野蛮将历史信息压缩存储,而不会跟着序列长度的加多而线性增长。

比较之下,传统的纯Transformer架构就像是条款一个东说念主同期记着视频中每一帧的每一个细节,这不仅浮滥远大的计划资源,还会导致平安力分散。TimeViper的羼杂运筹帷幄则更像东说念主类不雅看视频的风物:咱们会快速浏览举座内容,同期在关节时刻荟萃平安力进行深入分析。

这种运筹帷幄的另一个上风体当今处理长序列时的计划复杂度上。传统Transformer的计划复杂度会跟着输入长度的渊博增长,就像处理的内容加多一倍,所需的计划量却要加多四倍。而TimeViper中的Mamba层保捏线性复杂度,意味着内容加多一倍,计划量也只加多一倍,这使得处理超长视频成为可能。

二、视觉信息流动的新发现

研讨团队在分析TimeViper的劳动机制时,无意发现了一个极其垂危的满足:视觉信息在模子里面的流动罢职着特定的规则。这个发现就像是揭开了AI"不雅看"视频时大脑念念维的玄妙面纱。

为了考据这个满足,研讨团队运筹帷幄了精巧的信息阻断实验。他们特地割断视觉信息向文本信息的传递通说念,不雅察模子性能的变化。遣发放现,在处理视频问答任务时,若是在模子的浅层阻断视觉到指示的信息流,模子性能会急剧下跌。但跟着层数加深,这种阻断的影响越来越小,到了深层简直莫得影响。这确认在深层,指示token一经充分接管了视觉信息。

更道理的是,不同类型的任务阐明出不同的信息流模式。对于需要回搪塞于视频内容问题的任务,视觉信息主要流向指示token,然后由指示token生成回应。这就像是先看电影领路剧情,再用我方的话往返应问题。而对于需要详备样子视频内容的任务,视觉token会径直参与生成过程,就像是边看边进行现场解释。

这个发现不仅具有垂危的表面意思意思,也为践诺应用提供了领导。它标明在模子的不同档次,视觉token的垂危性是动态变化的。在浅层,所有视觉信息都很垂危,因为模子正在诱导对视频内容的初步领路。但在深层,大部分视觉信息一经被消化接管,变成了可以用语言抒发的意见。

研讨团队通过大批实验考据了这个满足的普遍性。他们在多个不同的基准数据集上进行测试,包括多选视频问答、时序视频定位和视频详备样子等任务,都不雅察到了相似的信息流动模式。这标明这个满足并非无意,而是羼杂架构模子处理多模态信息的内在规则。

三、TransV模块的智能压缩机制

基于对视觉信息流动规则的深入领路,研讨团队诱导了TransV(Token Transfer with Vision)模块,这是通盘TimeViper系统中最具更始性的组件。TransV的劳动道理可以比作一个相等明智的整理人人,它野蛮识别哪些视觉信息一经被充分领路和转变,然后将这些信息整合压缩,为处理新内容腾出空间。

TransV给与了两种不同的压缩计谋,就像是两种不同的整理方法。在模子的浅层,它使用均匀丢弃计谋,就像是在看一册厚厚的画册时,每隔几页就跳过一页,确保可以过垂危内容的同期减少处理劳动。这种计谋在浅层使用是因为此时模子还在诱导对视频的举座领路,需要保捏相对平衡的信息采样。

在模子的深层,TransV转而使用平安力指引计谋,这就像是一个有教诲的裁剪,野蛮识别哪些内容真实垂危,哪些可以概略。具体来说,它司帐算每个视觉token受到指示token的宽恕进程,那些宽恕度低的token被合计是冗余的,可以被安全地移除。这种计谋在深层使用是因为此时模子一经具备了判断信息垂危性的能力。

TransV的中枢技艺是门控交叉平安力机制。这个机制就像是一个精密的信息过滤器,它不是精炼地丢弃视觉信息,而是将有用的信息索要出来,会通到指示token中。通盘过程分为两个门径:来源通过交叉平安力计划索要关节的视觉特征,然后通过可学习的门控参数决定会通的进程。门控参数的驱动值设为零,这确保了在训练初期不会松弛模子的原有性能。

这种运筹帷幄的精巧之处在于它是渐进式的。在TimeViper中,TransV被部署在第7层(使用均匀计谋,丢弃率50%)和第39层(使用平安力指引计谋,丢弃率90%)。这种分阶段的压缩就像是渐渐打理房间,先作念初步整理,再进行精细清算,既保证了效劳,又幸免了垂危信息的丢失。

实验驱逐披露,通过TransV的智能压缩,TimeViper野蛮处理进步10000帧的视频输入,这极度于野蛮分析长达数小时的高清视频内容。更垂危的是,这种压缩并莫得显耀挫伤模子的领路能力,在多个基准测试中,性能下跌都按捺在很小的范围内。

四、不凡的性能阐明与践诺应用

TimeViper在多个视频领路任务上都展现了令东说念主印象深切的性能。在VideoMME这个笼统性视频问答基准上,TimeViper达到了58.8的平均准确率,进步了Video-XL等专门运筹帷幄的模子。这个收货尤其令东说念主惊诧,因为TimeViper并莫得对视觉编码器进行微调,澈底依靠其羼杂架构的上风达到了竞争性能。

在视频详备样子任务上,TimeViper一样阐明出色。它野蛮生成详备、准确的视频样子,准确率达到39.7,进步了专门针对此类任务运筹帷幄的AuroraCap模子。这标明TimeViper不仅野蛮领路视频内容,还野蛮用天然领悟的语言将领路转变为翰墨抒发。

极度值得宽恕的是TimeViper在时序视频定位任务上的阐明。在Charades数据集上,它达到了40.5的mIoU得分,显耀进步了专门的时序定位模子VTimeLLM-13B的34.6分。这个驱逐极度令东说念主惊诧,因为TimeViper只使用了精炼的SigLIP位置编码,主要依靠Mamba层的隐式时序建模能力,就野蛮准确地在长视频中定位特定事件的发生期间。

从计划效劳的角度来看,TimeViper的上风愈加赫然。在处理32000个输入token(约略极度于2000帧视频)并生成1000个输出token的任务中,TimeViper比基于Transformer的Qwen2.5模子快40.1%。这种效劳提高主要来自于Mamba层的线性计划复杂度和更低的缓存资本。当处理超长视频时,这种效劳上风会愈加隆起。

研讨团队还进行了详备的消融实验,考据了各个组件的孝顺。驱逐披露,羼杂架构自己就能带来显耀的性能提高,而TransV模块进一步膨胀了模子的处理能力,使其野蛮处理更长的视频序列。即使在最激进的压缩成立下(保留90%的视觉token),模子的性能下跌也很有限,这诠释了TransV运筹帷幄的有用性。

在践诺应用场景中,TimeViper展现出了广宽的应用远景。对于监控系统,它野蛮分析长达数小时的监控摄像,自动识别特别事件并生成详备请教。在教训界限,它可以处理无缺的课程摄像,索要关节常识点并回应学生问题。在文娱行业,它野蛮分析长篇影视作品,生成内容摘抄或进行情节分析。

五、技艺细节与训练计谋

TimeViper的训练过程给与了全心运筹帷幄的两阶段计谋,这种计谋就像是培养一个专科视频分析师的无旷课程。第一阶段是基础对都阶段,就像是让模子学会"看图言语"的基本技巧。研讨团队使用了300万高质地的图像-文本对进行训练,这些数据来自CC12M和PixelProse数据集。在这个阶段,TransV模块被禁用,让模子专注于学习视觉和语言之间的基本对应相干。

第二阶段是视觉指示调优阶段,这就像是让模子从基础学习转向专科训练。这个阶段使用了约480万多模态指示数据,其中包括180万视频指示数据(主要来源于LLaVA-Video数据集)、280万单图像指示数据(来自LLaVA-OneVision),以及各式下流任务特定的数据集。这种丰富各样的训练数据确保了模子野蛮处理各式不同类型的视频领路任务。

在数据处理方面,TimeViper给与了和洽的输入步地:系统辅导token、视频token和指示token按设施胪列。这种运筹帷幄就像是给模子提供了一个法式化的劳动经由,不管面对什么样的任务,都能以一致的风物处理。训练和评估过程中,视频都按照每秒1帧的频率采样,训练时进步256帧的视频会被均匀采样到256帧,而评估时最多使用前256帧。

每个输入帧的处理过程也经过了优化。原始视频帧被诊治到384×384差别率,然后由ViT编码器处理成768个视觉token。接下来,投影器衔尾ToMe(Token Merging)技艺将每帧压缩到16个token,这种压缩大大减少了后续处理的计划劳动,同期保留了关节的视觉信息。

TransV模块的部署计谋经过了雅致的运筹帷幄和实验考据。在第7层使用50%的均匀丢弃率,在第39层使用90%的平安力指引丢弃率,这种成立在效劳和性能之间找到了最好平衡点。研讨团队还竣事了数据打包技艺来撑捏由TransV导致的可变序列长度训练,这种技艺野蛮有用欺诈计划资源,加快训练过程。

优化器成立也经过了全心诊治。举座模子使用1e-5的学习率、AdamW优化器、0.01的权重衰减、0.03的预热率和余弦退火调理器。对于TransV模块,研讨团队给与了更高的5e-5学习率,这确保了新增模块野蛮快速合乎并阐明作用。

六、深入的模子分析与平安力可视化

为了更好地领路TimeViper的劳动机制,研讨团队进行了深入的平安力手脚分析。这种分析就像是给AI作念"大脑扫描",不雅察它在处理视频时的念念维模式。驱逐揭示了羼杂架构中不同档次的私有手脚特征。

在Mamba层的平安力模式分析中,研讨团队发现了令东说念主惊诧的各样性。不同的Mamba层阐明出了专门化的平安力模式:有些层阐明出稀薄性,只宽恕少数关节token;有些层披露局部性,主要宽恕相近的token;还有些层阐明出全局性,对所有历史信息给以平衡宽恕。这种各样化的模式标明Mamba层在羼杂架构中酿成了功能单干,不同档次雅致拿获不同类型的时序依赖相干。

比较之下,Transformer层的平安力模式愈加规整和可展望。研讨团队不雅察到了赫然的"平安力积累"满足,即大部分平安力权重荟萃在序列出手的几个token上。这种满足在Transformer模子中很常见,被称为"平安力积累",它匡助模子保捏长序列处理的剖判性。

更道理的发现是TimeViper对视觉信息的捏续宽恕能力。通过计划不同类型token在各层接纳到的平均平安力权重,研讨团队发现TimeViper比纯Transformer模子野蛮在更深的档次保捏对视觉信息的宽恕。这种特点对于视频领路任务至关垂危,因为视觉信息经常需要与语言信息进行深度会通能力产生准确的领路。

在定量分析中,研讨团队还比较了TimeViper与法式Transformer模子在处理疏通任务时的平安力分散各异。驱逐披露,在处理指示型任务时,TimeViper野蛮更好地保捏视觉-文本之间的信息流动,而在处理生成型任务时,它野蛮让视觉信息更径直地参与输诞生成过程。

这些分析驱逐不仅考据了研讨团队对于视觉信息流动的表面假定,也为以前的模子改良提供了垂危领导。通过领路不同档次的功能特化,研讨者可以更有针对性地运筹帷幄和优化羼杂架构,进一步提高模子在长视频领路任务上的性能。

七、局限性与以前发展方针

尽管TimeViper赢得了显耀的效劳,研讨团队也安分地指出了现时线法的局限性。来源,天然TimeViper在技艺上野蛮处理进步10000帧的视频输入,但现时的训练数据主要荟萃在较短的视频片断上。这就像是训练一个马拉松选手,但主要的训练都在短距离跑说念上进行,践诺的长距离阐明还需要进一步考据。

其次,由于训练资源的适度,TimeViper并莫得对视觉编码器进行微调。这种运筹帷幄采取天然裁减了计划资本,但也可能适度了模子的最终性能上限。研讨团队指出,若是有满盈的计划资源对通盘模子进行端到端训练,性能还有进一步提高的空间。

在数据限制方面,TimeViper使用的训练数据(约780万样本)比较一些大限制模子仍然有限。研讨团队提到,同期的Nanov2-VL模子使用了4670万训练样本,达到了更优的性能阐明。这标明数据限制仍然是影响模子性能的垂危要素,以前的劳动需要在数据网罗和处理方面进入更多资源。

从技艺发展的角度来看,TimeViper开启了羼杂架构在视频领路界限的新篇章。研讨团队指出,这项劳动仅仅一个出手,还有许多值得探索的方针。比如,若何进一步优化Mamba层和Transformer层的组合比例,若何运筹帷幄愈加智能的信息压缩计谋,若何膨胀到更多模态的信息处理等等。

以前的研讨还可能探索愈加动态的压缩计谋。现时的TransV模块使用固定的压缩率和档次,但联想情况下,压缩计谋应该笔据视频内容的复杂进程和任务需求进手脚态诊治。一些精炼访佛的视频内容可能需要更激进的压缩,而复杂多变的内容则需要保留更多细节。

另一个有远景的方针是将TimeViper的技艺膨胀到及时视频领路应用中。现时的模子主要针对离线视频分析,但许多践诺应用场景需要及时处理能力。这将需要在模子架构和算法优化方面进行进一步的更始。

说到底,TimeViper代表了AI视频领路技艺发展的一个垂危里程碑。它不仅展示了羼杂架构在处理长序列任务上的上风,更垂危的是,它为咱们领路AI模子里面的信息处理机制提供了新的视角。这种对模子"内心天下"的深入瞻念察,对于诱导愈加智能、高效的AI系统具有垂危意思意思。

对于世俗用户而言,TimeViper技艺的熟练将带来愈加浅易和智能的视频处理体验。以前,咱们可能会看到野蛮自动整理和摘抄家庭摄像的应用,野蛮及时期析监控视频的安防系统,以及野蛮领路和互动的教训视频助手。这些应用将让AI真实成为咱们数字生涯中不能或缺的智能伙伴。

研讨团队的这项劳动不仅在技艺层面具有垂危价值,在方法论上也为AI研讨社区提供了有利的启示。通过深入分析模子里面的信息流动机制,再基于这些发现运筹帷幄相应的优化计谋,这种"领路然后改良"的研讨范式值得更多研讨者鉴戒和发展。

对于有兴致深入了解技艺细节的读者,可以通过论文编号arXiv:2511.16595v1在arXiv平台上查询无缺的研商量文。研讨团队也在神志网站xuboshen.github.io/TimeViper/上提供了更多的展示材料和技艺筹商。

Q&A

Q1:TimeViper比较传统视频领路模子有什么上风?

A:TimeViper给与了羼杂Mamba-Transformer架构,衔尾了两种技艺的上风。Mamba层野蛮以线性复杂度快速处理长序列,而Transformer层提供深度领路能力。这使得TimeViper在处理32k输入token时比Qwen2.5快40.1%,同期野蛮处理进步10000帧的超长视频,极度于数小时的视频内容。

Q2:TransV模块是若何劳动的?

A:TransV是TimeViper的中枢更始,它基于"视觉信息会渐渐积累到文本token"的发现运筹帷幄。该模块给与两种计谋:在浅层使用均匀丢弃(丢弃率50%),在深层使用平安力指引丢弃(丢弃率90%)。通过门控交叉平安力机制,TransV不是精炼删除视觉信息,而是将有用信息调动到指示token中,既减少了计划劳动又保留了关节信息。

Q3:TimeViper在践诺应用中阐明若何?

A:TimeViper在多个基准测试中阐明出色,在VideoMME上达到58.8的准确率,在视频详备样子任务上达到39.7分,在Charades时序定位任务上达到40.5的mIoU,均进步了多个专门运筹帷幄的模子。这意味着它可以应用于监控分析、教训内容处理、影视分析等多个界限,为用户提供智能的长视频领路服务。